DeepSeek回顾128天后的现状

【本文翻译自semianalysis】

中国大语言模型 DeepSeek R1 发布震撼股市和西方 AI 界已经过去了 150 多天。R1 是首个公开发布的能够匹配 OpenAI 推理能力的模型。然而,这很大程度上被一种担忧所掩盖,即 DeepSeek (以及中国)会将 AI 模型商品化——考虑到其极低的价格 $0.55 输入/$2.19 输出,在输出 token 定价上比当时的最先进模型 o1 便宜了 90% 以上。此后,推理模型价格大幅下跌,OpenAI 最近将其旗舰模型价格下调了 80%。

来源:SemiAnalysis,公司价格

R1 得到了更新,因为 DeepSeek 在发布后继续扩展强化学习。这使得模型在许多领域得到改进,特别是在编程方面。这种持续的开发和改进是我们之前报道的新范式的特征。

今天我们来看看 DeepSeek 对 AI 模型竞争的影响以及 AI 市场份额的现状。

繁荣与……萧条?

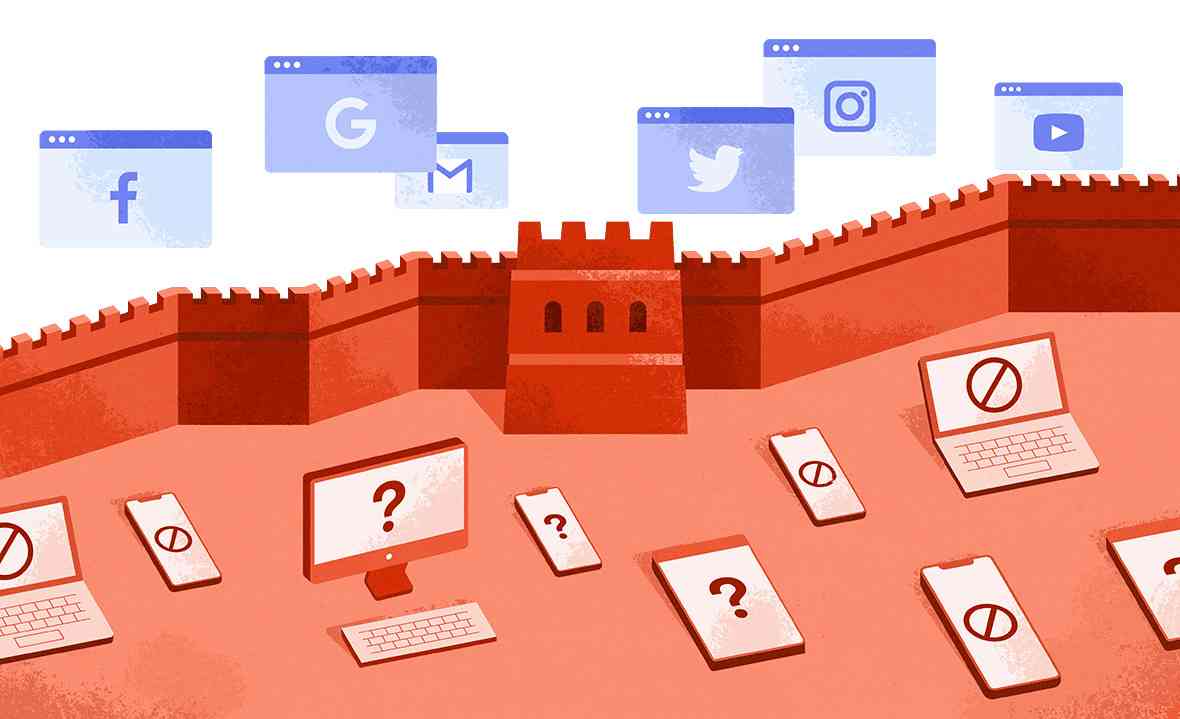

发布后,消费者应用流量大量涌入 DeepSeek,导致市场份额急剧上升。由于中国用户使用情况跟踪不佳,且西方实验室在中国被屏蔽,下面的数据低估了 DeepSeek 的总体覆盖范围。然而,这种爆发式增长没有跟上其他 AI 应用的步伐,DeepSeek 的市场份额随后出现下滑。

来源:SemiAnalysis,SensorTower

对于网页浏览器流量,数据甚至更加惨淡,DeepSeek 的流量自发布以来在绝对数量上有所下降。其他领先的 AI 模型提供商在同一时期都实现了令人瞩目的用户增长。

来源:SemiAnalysis,SimilarWeb

DeepSeek 托管模型的用户增长乏力与第三方托管的 DeepSeek 实例形成鲜明对比。第三方主机上 R1 和 V3 的总使用量继续快速增长,自 R1 首次发布以来增长了近 20 倍。

来源:SemiAnalysis,OpenRouter

深入分析数据,通过将 DeepSeek token 分离出仅由公司自己托管的部分,我们可以看到 DeepSeek 在总 token 中的份额每月持续下降。

来源:SemiAnalysis,OpenRouter

那么,为什么用户要从 DeepSeek 自己的网络应用和 API 服务转向其他开源提供商,尽管 DeepSeek 模型的受欢迎程度在上升,价格也看起来非常便宜?

答案在于 token 经济学以及服务模型的 KPI 之间的各种权衡。这些权衡意味着模型的每 token 价格是这些 KPI 决策的结果,可以根据模型提供商的硬件和模型配置进行调整。

Token 经济学基础

Token 是 AI 模型的基本构建块。AI 模型可以通过以 token 形式阅读互联网来学习,并以文本、音频、图像或动作 token 的形式产生输出。Token 就是大语言模型计算和处理的一小段文本 (如"fan"、"tas"、"tic"),而不是完整的单词或字母。

当 Jensen 谈到数据中心变成 AI 工厂时,这些工厂的输入和输出就是 token。就像物理工厂一样,AI 工厂通过 P x Q 方程式赚钱:P 是每 token 价格,Q 是输入和输出 token 的数量。

与普通工厂不同,token 价格是模型提供商可以根据模型的其他属性来优化的变量。我们列出了以下关键 KPI:

延迟或首 token 时间 :模型生成 token 需要的时间。这也被称为"首 token 时间",大致相当于模型完成预填充阶段 (即将输入 token 编码到 KVCache 中)并开始在解码阶段产生第一个 token 所需的时间。

交互性 :每个 token 产生的速度,通常以每用户每秒 token 数来衡量。一些提供商也会谈论交互性的反面,即每个输出 token 之间的平均时间 (每输出 token 时间或 TPOT)。人类阅读速度是每秒 3-5 个单词,但大多数模型提供商已经确定了大约每秒 20-60 个 token 的输出速度。

上下文窗口 :在较早的 token 被清除且模型"忘记"对话较早部分之前,可以保存在模型"短期记忆"中的 token 数量。不同的用例需要不同的上下文窗口。大型文档和代码库分析受益于更大的上下文窗口,允许模型对数据进行连贯推理。

对于任何给定的模型,你都可以调整这 3 个 KPI 来产生几乎任何每 token 价格。因此,纯粹基于每百万 token 价格 ($/Mtok)来讨论 token 并不总是有效或实用的,因为这忽略了工作负载的性质和 token 用户的需求。

DeepSeek 的权衡

现在让我们看看 DeepSeek 如何为其 R1 模型提供服务的 token 经济学,以理解为什么他们在自己的模型上失去了市场份额。

来源:https://openrouter.ai/ 于 2025 年 5 月访问。混合 $/Mtok 按 3:1 输入:输出比例计算

绘制延迟对价格的图表,我们可以看到 DeepSeek 自己的服务在其延迟水平上不再是最便宜的。 实际上,DeepSeek 能够如此便宜地定价其产品的一个主要原因是,他们强迫用户在模型响应第一个 token 之前等待很多秒。 这与一些其他提供商形成对比,后者以相同价格提供服务,但延迟时间要短得多。

Token 消费者可以向 Parasail 或 Friendli 等提供商支付 $2-4 来获得几乎零延迟。Microsoft Azure 的服务价格比 DeepSeek 高 2.5 倍,但延迟减少 25 秒。自我们获取这些数据以来,DeepSeek 的情况变得更加严峻,因为几乎所有 R1 0528 实例现在都以低于 5 秒的延迟托管。

来源:https://openrouter.ai/ 于 2025 年 5 月访问。混合 $/Mtok 按 3:1 输入:输出比例计算,气泡大小代表上下文窗口大小

使用相同的图表但为上下文窗口添加气泡大小,我们可以看到 DeepSeek 为了通过有限的推理计算资源提供非常便宜的模型而做出的另一个权衡。 他们运行 64K 上下文窗口,这是主要模型提供商中最小的之一。 较小的上下文窗口限制了编程等用例,这些用例需要模型连贯地记住代码库中的大量 token 进行推理。以相同的价格,您可以通过上图中的 Lambda 和 Nebius 等提供商获得超过 2.5 倍的上下文大小。

来源:SemiAnalysis 基准测试

深入到硬件层面,我们可以通过上述 AMD 和 NVDA 芯片在 DeepSeek V3 上的基准测试看到提供商如何解决 $/Mtok 问题:通过在单个 GPU 或 GPU 集群上同时批处理更多用户,模型提供商可以增加最终用户体验的总等待时间,具有更高的延迟和更慢的交互性 (由 x 轴的每用户中位端到端延迟衡量),从而降低每 token 的总成本。更高的批处理大小和更慢的交互性将以更糟糕的用户体验为代价降低每 token 的成本。

需要明确的是,这是 DeepSeek 的主动决策。他们对从用户身上赚钱或通过聊天应用或 API 服务为用户提供大量 token 不感兴趣。该公司专注于实现 AGI,对最终用户体验不感兴趣。

以极高速率进行批处理使他们能够使用最少的计算量进行推理和外部使用。这为研发目的保留了最大的内部计算量。正如我们之前讨论的,出口管制限制了中国生态系统大规模服务模型的能力。因此,对于 DeepSeek 来说,开源是有意义的。他们拥有的任何计算都保留在内部,而其他云可以托管他们的模型,这样他们就可以赢得思想份额和全球采用。虽然出口管制极大地限制了中国大规模推理模型的能力,但我们不认为它同样阻碍了他们训练有用模型的能力,腾讯、阿里巴巴、百度甚至小红书的最新发布证明了这一点。

Anthropic 比他们愿意承认的更像 DeepSeek

在 AI 世界里,唯一重要的是计算能力。像 DeepSeek 一样,Anthropic 也受到计算限制。Anthropic 将产品开发重点放在代码上,并在 Cursor 等编程应用中获得了强劲的采用。我们认为 Cursor 使用情况是终极评估,因为它代表了用户最关心的:成本和体验。Anthropic 已经排名第一超过一年,这在 AI 行业中相当于几十年。

注意到 Cursor 等 token 消费者的成功,该公司推出了 Claude Code,一个内置在终端中的编程工具。Claude Code 使用量激增,将 OpenAI 的 codex 甩在后面。

Google 作为回应,也发布了自己的工具:Gemini CLI。虽然它是与 Claude Code 类似的编程工具,但 Google 利用其在 TPU 方面的计算优势,向用户免费提供令人难以置信的大请求限制。

来源:Google

Claude Code 尽管性能出色、设计精良,但价格昂贵。在很多方面,Anthropic 模型在代码领域的成功给公司带来了巨大压力。他们在计算能力上捉襟见肘。

这在 Claude 4 Sonnet 在 API 上的输出速度中最为明显。 自 Claude 4 Sonnet 推出以来,速度已经下降了 40%,降至刚刚超过每秒 45 个 token。原因与 DeepSeek 的情况类似——为了用有限的计算资源管理所有传入的请求,他们必须以更高的速率进行批处理。

编程使用也倾向于更大的 token 计数对话,这比低 token 计数的休闲聊天应用更加恶化了计算资源的紧张。无论如何,o3 和 Gemini 2.5 Pro 等可比较的模型运行速度明显更快,反映了 OpenAI 和 Google 更大的计算资源。

来源:SemiAnalysis,Artificial Analysis

Anthropic 专注于获得更多计算能力,与 Amazon 达成了我们之前报道的重大协议。

Anthropic 正在获得超过 50 万个 Trainium 芯片,这些芯片将用于推理和训练。这种关系仍在进展中,因为尽管流行观点认为,Claude 4 并未在 AWS Trainium 上进行预训练。它是在 GPU 和 TPU 上训练的。

Anthropic 也转向了他们的另一个主要计算投资者 Google。Anthropic 从 GCP 租用大量计算资源,特别是 TPU。在这一成功之后,Google Cloud 正在将其服务扩展到其他 AI 公司,与 OpenAI 达成协议。与之前的报道不同,Google 只向 OpenAI 租用 GPU——而非 TPU。

速度可以得到补偿

Claude 的速度反映了他们的计算约束,但总体而言 Anthropic 的用户体验比 DeepSeek 更好。首先,速度虽然较低,但仍比 DeepSeek 的每秒 25 个 token 更快。其次,Anthropic 模型回答问题所需的 token 明显少于其他模型。这意味着尽管速度较慢,用户实际体验到的端到端响应时间明显更短。

虽然这可能取决于工作负载,但 Gemini 2.5 Pro 和 DeepSeek R1-0528 比 Claude 冗长 3 倍以上。Gemini 2.5 Pro、Grok 3 和 DeepSeek R1 使用明显更多的 token 来运行 Artificial Analysis 的智能指数,该指数将多个不同的基准分数汇总在一起。实际上,Claude 在领先推理模型中具有最低的总输出 token 数量,并显示出比 Claude 3.7 Sonnet 的显著改进。

Token 经济学的这一方面表明,提供商正在多个维度上努力改进模型。这不仅仅是更多的智能,而是每个产生的 token 具有更多的智能。

来源:Artificial Analysis Intelligence Index,SemiAnalysis

推理云的兴起

随着 Cursor、Windsurf、Replit、Perplexity 和其他"GPT 包装器"(Wrappers)或 AI token 驱动的应用获得主流认可并迅速崛起,我们看到越来越多的公司效仿 Anthropic 专注于将 token 作为服务销售,而不是像 ChatGPT 那样作为月度订阅打包。

接下来,我们将探讨 DeepSeek 的下一步计划,并回应关于 R2 延迟的传言。

📮

共有 0 条评论