为什么95的AI智能体都翻车了真正好用的那5做对了什么

你有没有发现,身边那些号称“AI 驱动”的产品越来越多?

“AI 秘书”“AI 助理”“AI 管家”……个个都吹得天花乱坠。

可真正让你觉得“哇,这玩意我离不开”的,有几个?

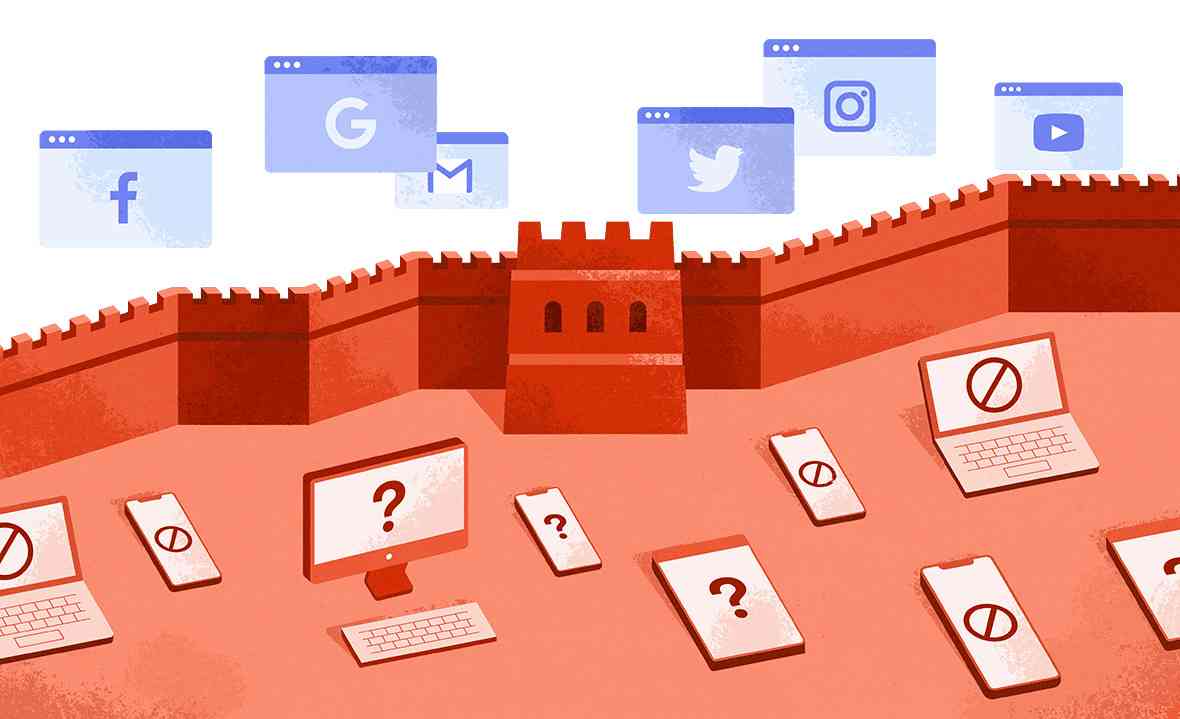

事实可能比你想象的更扎心: 高达 95% 的 AI 智能体,根本活不到上线那天。

不是 AI 不够聪明,而是——我们压根没教会它怎么理解人。

最近读到一场在旧金山的闭门讨论,挺有意思。Uber、WisdomAI 这些公司的工程师围坐一圈,聊的不是“怎么写更好的提示词”,而是:为什么绝大多数 AI 项目,一进真实世界就崩?

他们的答案让我恍然大悟:我们总盯着模型多强,却忘了 AI 不是靠“聪明”活着的,它是靠“设计”活下来的。

1. 别再迷信“提示词”了,真正的功夫在“上下文工程”

很多人以为,只要提示词写得好,AI 就能无所不能。(有时候我也是这么想的😳)

“请扮演营销专家”“请生成一份专业报告”……听起来很厉害,对吧?

但用久了你会发现,AI 像个“会背书但没灵魂的实习生”——话都说对了,就是不中用。

问题出在哪?不在模型,而在上下文。

有个比喻特别戳我: 大模型是土壤,上下文才是种子。

你给它一堆杂草,就别指望长出玫瑰。

AI 要回答问题,就像人写作文。你给它的“上下文”越合适,答案就越靠谱。

这一点,我特别有体会,很多时候我使用这些 AI 工具都不是仅靠一个提示词然后等待“抽卡”,而是会经过多次的反复补充上下文信息,最终会得到一个满意的结果。

真正靠谱的团队,会像老厨师备菜一样,精心准备 AI 的“食材”,不是什么都塞给它,而且要确保给它的信息是新的、准的以及能看得懂的(结构化的)。

说白了,LLM 只是大脑,上下文才是它看世界的眼睛。

2. “记忆”不是聊天记录,而是一门信任的艺术

几乎所有产品都想让 AI “记住你”。 但这里有个微妙的边界:贴心和毛骨悚然,只一线之隔。

想象一下,你让 AI 推荐一部电影,它却精准地说出你孩子的名字。你会觉得贴心,还是背脊发凉?我用 ChatGPT 偶有就有这样的感觉。

好的记忆设计,是分层的:

个人层 :记住个人偏好,比如你喜欢柱状图还是饼图、喜欢鲁迅风格还是莫言风格

团队层 :记录部门常见问题,比如知道你们部门常查哪些数据;

公司层 :记住公司的企业文化、规章制度、历史决策等。

但更重要的是:你能看见它记了什么,也能随时删掉。

否则,再聪明的记忆,也只是监控。

3. AI 不是万能的,人永远在环路里

别被“全自动”、“智能体”这些词忽悠了。 在涉及钱、安全、医疗的地方,信任才是最大的门槛。

即便不是这些领域,在任何严肃的工作中,你都不该完全放手 AI 来做事情。

就像我朋友说的:“我老婆死活不让我开特斯拉的自动驾驶——不是觉得它不好,是她不信它。”

那成功的 5%,都做对了一件事: 把 AI 当助手,不是替身。

关键输出,人能一眼验证;出了错,人能立刻覆盖;系统还会从你的修正里学习。

我特别反感很多智能体的营销广告,就跟之前吹自动驾驶一样,让你感觉可以完全不用自己动手,这样的结果就等于你把命都交给它了。

一个很简单的道理,就连最先进的模型都会“幻觉”,你凭什么相信这些智能体能独自做决定?

所以啊,别急着放手。人机协同,才是现在最稳的姿势。

4. 聊天框不是万能的,好产品懂得“该说就说,该点就点”

自从 ChatGPT 火了,好像所有 AI 都得塞进一个聊天框。 但说实话,叫个网约车,我宁愿“点点点”,也不想跟手机唠嗑。

自然语言确实能降低门槛——比如让新手也能查数据、写代码。 可一旦有了结果,谁不想直接拖拽调整?把饼图换成柱状图,打字多累啊!

真正聪明的产品,是混合交互:用聊天“进门”,零学习成本;用图形界面“干活”,高效又安心。

AI 出图(比如即梦)就是个好例子:先打字描述,生成后立刻切到图形编辑——祛痘、去水印、局部重绘,点选就行。这时候,GUI 比嘴快多了。

5. 好的AI系统,会“看菜吃饭”

很多人以为 AI 就是调 GPT-4(或者其他某模型) 一劳永逸。 但真正高效的系统,更像个“精打细算的管家”:

简单问题(比如查天气),交给本地小模型,又快又便宜;

复杂分析,才请大模型出马;

关键决策,甚至让两个模型互相校验,防出错。

这叫“模型编排”——不是炫技,而是让 AI 在速度、成本和准确之间,找到最佳平衡。

而且它还能越用越聪明:哪些任务小模型就能搞定?哪些必须上“王牌”?系统自己会学。

未来的 AI,不是“一个模型打天下”,而是会调度、懂分寸的协作者。

✍️ 写在最后

这场讨论让我想通了一件事:

真正能跑起来的 AI,拼的从来不是谁家模型更大、API 更快,而是四个扎扎实实的“基本功”:

上下文质量——它能不能听懂你话里的真正意思;

记忆设计——它会不会记得你是谁、习惯什么;

编排可靠性——它能不能在成本、速度和准确之间聪明权衡;

信任与体验——你敢不敢把重要的事交给它。

95% 的 AI 智能体失败,不是因为模型不够强,而是因为这些“支架”没搭好。

AI 不是调用出来的,是设计出来的。

所以下次你再用一个 AI 工具,你也可以从这四个方面来审视它。别只问“它聪明吗?”,也问问:“它真的懂我吗?”

💬 如果你也在用 AI(工作 or 生活),欢迎聊聊: 你遇到过最“懂你”、最“靠谱”的 AI 工具是什么? 或者,最让你觉得“这玩意根本不靠谱”的又是什么?

📮

共有 0 条评论